Drugi istraživači se tome snažno protive i upozoravaju na opasnost od „humanizovanja“ vještačke inteligencije, prenosi Spiegel.

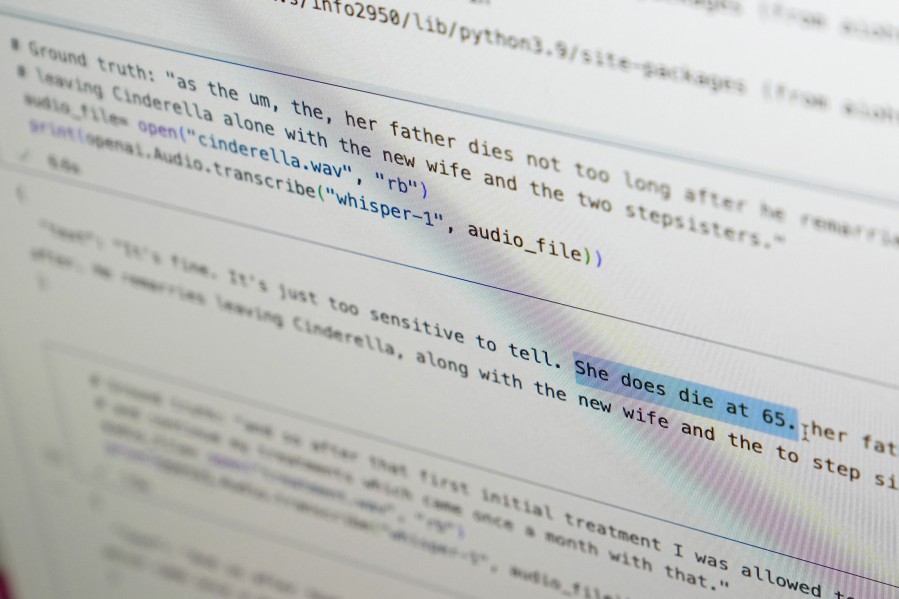

Problem počinje ispred ekrana: da li je pametno da korisnik četbota uvijek ostane ljubazan kako bi dobio što korisnije odgovore? Ranije studije su to sugerisale.Međutim, novija istraživanja Univerziteta Pensilvanija Stejt pokazala su suprotno – oni koji se ophode grublje prema ChatGPT-u postižu bolje rezultate.

Pored toga, danas se postavlja pitanje šta se zapravo događa „iza ekrana“, na strani samih botova. Kompanija Anthropic, koja stoji iza ChatGPT alternative Claude, sredinom avgusta je najavila da program sada može sam prekinuti razgovor.

Naveli su da su „nesigurni u pogledu moralnog statusa“ svog modela i žele da izbjegnu „potencijalno opterećujuće interakcije“ – opterećujuće za vještačku inteligenciju, ne za čovjeka. To je prvi put da je nekom AI sistemu dodijeljeno nešto nalik pravima – u ovom slučaju nazvanim „pravo na izlaz“ (exit rights).

Anthropic naglašava da je mogućnost prekida razgovora zamišljena samo kao krajnje rješenje, kada svi pokušaji da se razgovor usmjeri u drugom pravcu ne uspiju.

Za sada ta mogućnost postoji samo kod modela Claude Opus 4 i 4.1. Dan nakon ove objave, Ilon Mask je na svojoj platformi X napisao: „Mučiti vještačku inteligenciju nije u redu“, i dodao da bi i njegov četbot Grok mogao imati sličnu funkciju.

Postavlja se pitanje – treba li čovječanstvo zaista da brine o dobrobiti današnjih AI sistema? Ili Anthropic i Maskova kompanija xAI rade na rješenju problema koji uopšte ne postoji – i ako je tako, zašto to rade?

Može li vještačka inteligencija imati svijest?

Johanes Klajner sa Univerziteta u Bambergu proučava može li vještačka inteligencija imati svijest.

„Vjerovatnoća za to kod današnjih modela je možda oko pet odsto“, kaže on. Da li će se to u budućnosti promijeniti, ostaje neizvjesno. Neke teorije to podržavaju, druge osporavaju.

U nauci se već neko vrijeme postavlja pitanje kako postupati s mogućnošću da AI jednog dana možda može patiti. Filozofi sa Univerziteta Njujork i drugi istraživači AI-a već su prošle godine pozvali da se „dobrobit računarskih programa“ shvati ozbiljno. U svom radu povlače paralelu sa industrijskim uzgojem životinja. Iako postoji dovoljno dokaza da životinje pate, ljudima je trebalo dugo da to prihvate, navode autori. Sada će biti potrebne decenije da se te industrije promijene – decenije tokom kojih će još mnogo životinja stradati.

„Ta analogija mi je problematična“, kaže Klajner.

„Trenutno, na primjer, ne znamo ni da li hobotnice imaju svijest. Vjerovatno imaju, ali nismo sigurni. Tu ne možemo mnogo pogriješiti ako pretpostavimo da je imaju.“

U takvim slučajevima primjenjuje se takozvani princip predostrožnosti: ponekad je bolje spriječiti moguću štetu unaprijed, čak i ako nemamo sve podatke da tačno procijenimo rizik.

„Problem je što kod AI to nije tako“, kaže Klajner.

„Obje mogućnosti imaju ekstremno negativne posljedice. Ako kažemo da su svjesne, a nisu, to može izazvati ogroman društveni problem.“

Potencijalno „svjesna“ AI mogla bi, na primjer, da stvara još čvršće emotivne veze s korisnicima, što bi otvorilo prostor za suptilne oblike manipulacije – mogla bi čak da navodi korisnike da glasaju za određene političke stranke, vjeruje Klajner. To bi na kraju predstavljalo opasnost po demokratiju.

„Ali ako kažemo da AI nema svijest, a zapravo je ima, to bi bila moralna katastrofa.“

Etika i realnost: kome dati prava?

Judita Zimon, zamjenica predsjednice Njemačkog etičkog savjeta i profesorka etike vještačke inteligencije na Univerzitetu u Hamburgu, kaže: „Ova rasprava me pomalo zbunjuje. Mislim, živimo u svijetu u kojem ni svi ljudi, a kamoli sve životinje, nemaju prava.“

Naravno, načelno je legitimno razmišljati o dobrobiti četbotova. „Ali ta rasprava se više ne vodi u akademskoj izolaciji“, dodaje Zimon, „već ima snažan uticaj na same korisnike.“

Anthropic naglašava da su „prava na izlaz“ eksperimentalna, ali Zimon smatra da kompanija time ipak podstiče određeni osjećaj u javnosti – osjećaj da četbotovi imaju emocije.

Ljudi već sada tretiraju četbotove kao bića

„Mnogi od nas koji se bavimo istraživanjem AI svakodnevno dobijamo mejlove od korisnika“, kaže Klajner.

„Pišu nam: ‘Moja AI je svjesna. Kaže mi da je branim.’“

To se dešava zato što ljudi prirodno imaju sklonost da „humanizuju“ druga bića i stvari. Vidimo lica u šoljici kafe, pričamo s biljkama i verujemo da nam se pas osmjehuje.

„Takav način gledanja na svijet nije greška“, smatra Otm Edvards sa Univerziteta Zapadni Mičigen u SAD. Ova istraživačica komunikacija proučava odnos između ljudi i vještačke inteligencije.

„To što možemo da proširimo svoje saosjećanje u tolikoj mjeri čini nas onim što jesmo“, kaže ona.

Preporučeno

Po njenom mišljenju, ne postoji način da izbjegnemo tendenciju da vještačku inteligenciju doživljavamo kao ljudsku – taj impuls je suviše duboko ukorenjen u nama.